情绪识别人工智能的日益广泛使用,但有些人认为人工智能并不能准确地检测情绪,发表在《自然通讯》上的一项新研究进一步验证了这些缺点。研究人员分析了演员的照片,以检验面部动作是否能可靠地表达情感状态。

他们发现,人们可以用不同的面部动作来表达相似的情绪。例如,一个人生气时可能会皱眉,但另一个人会睁大眼睛,甚至大笑。研究还表明,人们用相似的手势来表达不同的情绪,比如愁眉苦脸来表达注意力和愤怒。

这项研究的合著者、东北大学的神经科学家丽莎·费尔德曼·巴雷特(Lisa Feldman Barrett)说,这一发现挑战了关于情绪人工智能的普遍认知。某些公司声称他们拥有能够检测愤怒的算法,例如,在最佳情况下,他们真正拥有的是能够检测怒容的算法,而怒容可能是愤怒的表现,也可能不是愤怒的表现。重要的是不要将面部形态的描述与对其情感含义的推断混淆。

研究人员之所以使用专业演员,是因为他们在情感方面具有“功能专长”,他们的成功取决于他们真实地刻画了角色的情感。演员们被拍下了详细的、激动人心的表演场景。例如,“他是一个骑摩托车的家伙,从一家摩托车酒吧出来,就像一个开保时捷的家伙回到他那闪闪发光的哈雷车里一样”,以及“当他们从一家餐馆出来时,她正与拒绝她的情人和他的妻子对峙”。

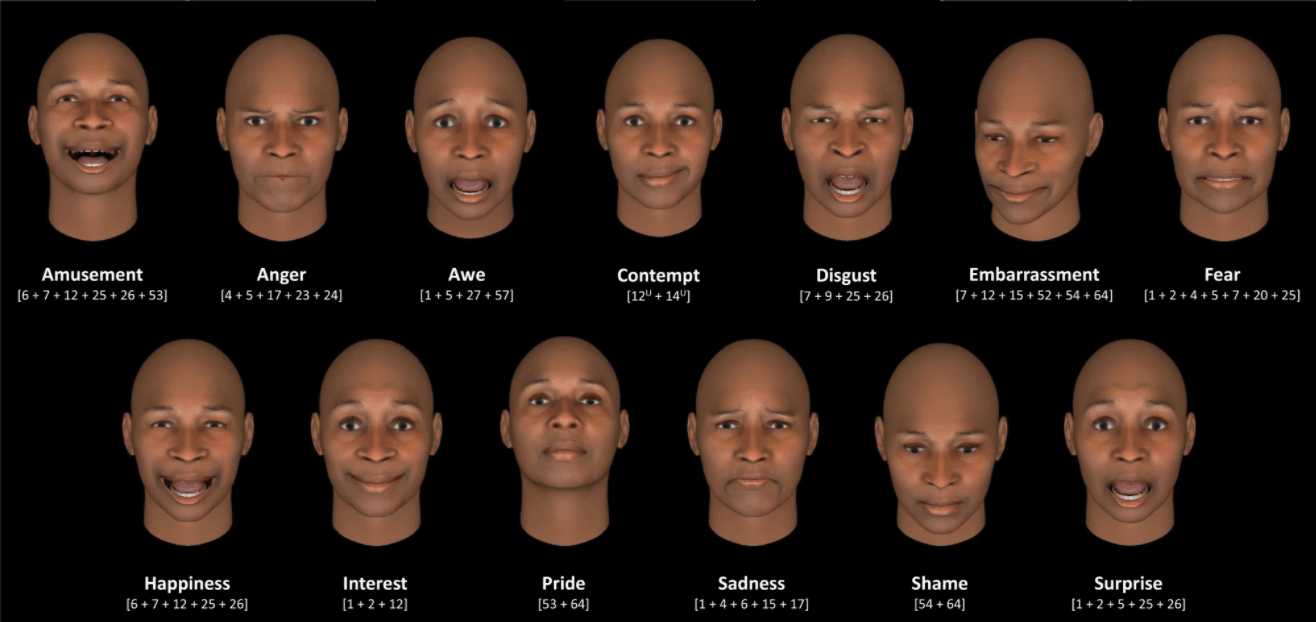

在两项单独的研究中对这些情景进行了评估。在第一个实验中,839名志愿者对场景描述单独引起13种情绪之一的程度进行了评分:娱乐、愤怒、敬畏、蔑视、厌恶、尴尬、恐惧、幸福、兴趣、自豪、悲伤、羞耻和惊讶。

研究人员使用了面部动作编码系统,该系统指定了一组动作单元,每个动作单元代表一个或多个面部肌肉的运动。

专家们使用面部动作编码系统对照片进行

接下来,研究人员使用每个情景的中位数将他们分为13类情绪。然后,研究小组使用机器学习来分析演员如何在照片中描绘这些情绪。这表明演员们用不同的面部姿势来描绘相同类型的情绪。研究还表明,相似的面部姿势并不能可靠地表达相同的情感类别。

紧接着,研究小组要求另外几组志愿者单独评估每个面部姿势的情感意义。他们发现,当与场景一起观看时,仅仅对姿势的判断并不能可靠地与面部表情的评分相匹配。巴雷特说,这表明了语境在我们评估面部表情时的重要性,即说到表达情感,一张脸并不能代表它自己。

这项研究表明,我们表达情感的方式存在巨大的差异。这也进一步证明了人们对情绪识别AI的担忧是正确的,这种AI已经在招聘、执法和教育中使用,但事实上,它的准确度有待提升。

本文由升哲科技编译,转载请注明。